Cosa è cambiato da quando l’AI ragiona: 13 cambiamenti concreti

- Massimiliano Turazzini

- 3 set 2025

- Tempo di lettura: 12 min

Un anno fa eravamo ancora lì, con i modelli che sembravano macchine miracolose ma che, a guardarle bene, non sapevano davvero ragionare, gli mancava qualcosa.

Scattavano subito al nostro prompt, senza pause dopo il nostro INVIO. Producevano velocemente il risultato che (più o meno) ci aspettavamo e cercavano pure di azzeccare qualche passaggio logico. Ma tendenzialmente rispondevano di getto.

Oggi ci troviamo in un paesaggio completamente diverso: i modelli più evoluti non si occupano più solo di generare testo, ma prima dedicano tempo a pensare, pianificare, usare strumenti.

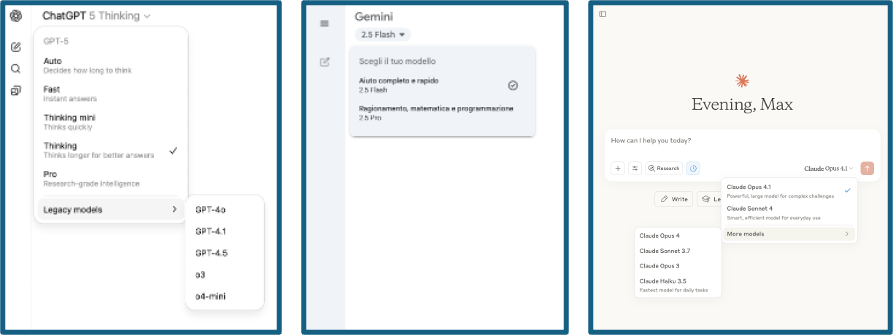

La maggior parte di noi se n’è accorta con GPT-5, ma tutti i modelli della serie O di OpenAI, DeepSeek, Claude, Gemini e molti altri hanno introdotto il concetto di ragionamento prima della risposta.

Da, pappagalli stocastici, come li chiama qualcuno, a pappagalli stocastici che Prima di Parlare Pensano. E questo ha cambiato di molto le cose.

I critici vi ricorderanno che non è ragionamento vero e proprio, né tantomeno la superintelligenza. Hanno ragione, ma non abbiamo un termine più chiaro per parlarne, idem per la parola 'intelligenza'.

Se guardate a questo indice di ‘intelligenza combinata’, il cambiamento è piuttosto evidente. In viola i modelli che ragionano messi in un indice di 'intelligenza'

Come siamo arrivati a far ragionare l'AI?

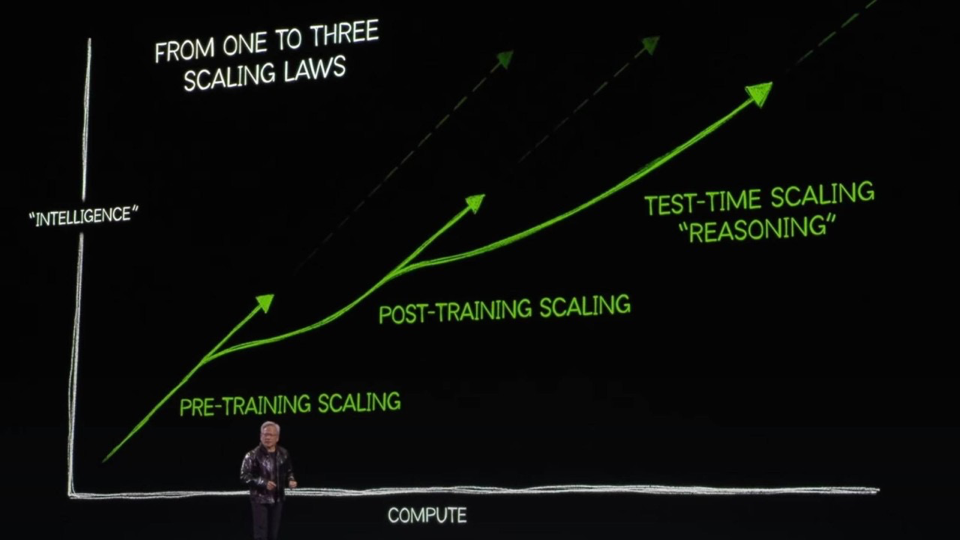

Inizialmente c'era una sola regola per i Modelli Generativi: più dati e più potenza = più intelligenza. Prima Scaling Law.

Poi si è capito che attraverso tecniche post-addestramento (sigle meravigliose come RL, DPO che vi risparmio qui) si potevano migliorare di molto le risposte (seconda Scaling Law - cosa che ha reso tra le altre famoso DeepSeek.)

E per finire il Test-Time scaling, ovvero il ‘reasoning’: tempo che concediamo all’AI per pensare a come rispondere a una richiesta (Che paghiamo direttamente in token).

Ed è proprio quest’ultima, il tempo di riflessione prima di rispondere, che ha abilitato molte delle cose che vi racconto qui.

È da qui che passa il filo rosso che collega tutte le trasformazioni dell’ultimo anno.

Cosa vuol dire che l’AI Ragiona?

Se vi accontentate di una risposta veloce: ve ne siete probabilmente accorti anche voi che prima di rispondervi, alcuni modelli, GPT-5 in particolar modo sulle richieste complesse, si mettono a pensare.

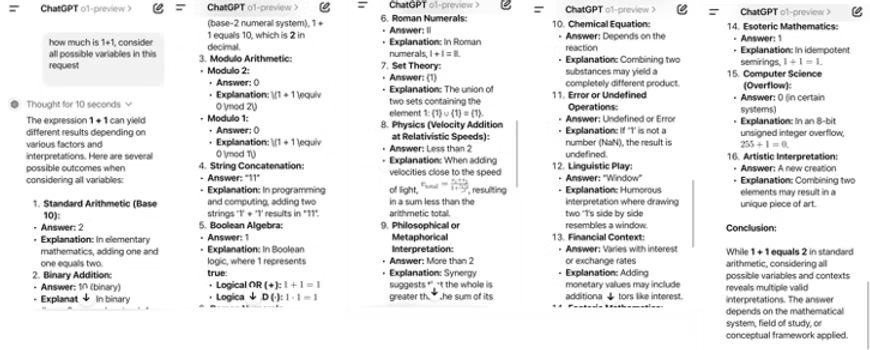

In questo esempio il ‘vecchio’ o1, primo modello di OpenAI rilasciato in questa direzione, pensava a quanto fa 1+1 per dieci secondi prima di risponderci.

Per approfondire vi lascio a due post che ho scritto qualche mese fa, in uno presento GPT-o1 e un altro su quando l’AI ha incontrato un muro, e l’ha infranto, appunto con il ragionamento.

Ma andiamo al dunque; eccovi quindi cosa è successo in soli dodici mesi, con il senno di poi.

Cosa è cambiato in un anno?

1. Gli LLM andavano fatti ragionare a mano

Per simulare un barlume di logica ci affidavamo a tecniche di prompting che simulavano catene di pensiero (le famose Chain-of-Thought), con template improvvisati, copiati da qualche Insta-guru che prometteva miracoli. Copia e incolla, hack qua e là, e via a sperare che la macchina seguisse la nostra direzione. Ma la verità era che non c’era nessuna riflessione: era un approccio 'io speriamo che me la cavo', almeno da parte di noi utenti ‘normali’.

Oggi

Il ragionamento è diventato parte integrante dell’AI. Non solo: è diventato la metrica. Abbiamo agenti AI capaci di vincere Olimpiadi di matematica, di affrontare problemi con vera logica. Li valutiamo non più soltanto su quanto scrivono bene, ma su quanto bene e a lungo riescono a pensare.

E la vera rivoluzione è questa: non chiediamo più una risposta immediata ai problemi più difficili, ci aspettiamo un pensiero. Parecchie persone trovano più interessante leggere i pensieri dell’AI piuttosto che la risposta.

È nata l’AI lenta, quella a cui vale la pena fare domande fatte bene, perché ci risponderà dopo molti minuti, a volte ore. Ed è spesso la risposta che aspettavamo.

2. Usare strumenti mentre il modello ragionava era impensabile

Un anno fa, chiedere a un modello di usare strumenti durante il ragionamento era difficile da immaginare. Dietro a una 'semplice chiamata API da parte di un LLM' c’erano trappole infinite che solo pochi sviluppatori esperti potevano affrontare. Bastava il più piccolo errore per far crollare tutto.

Oggi

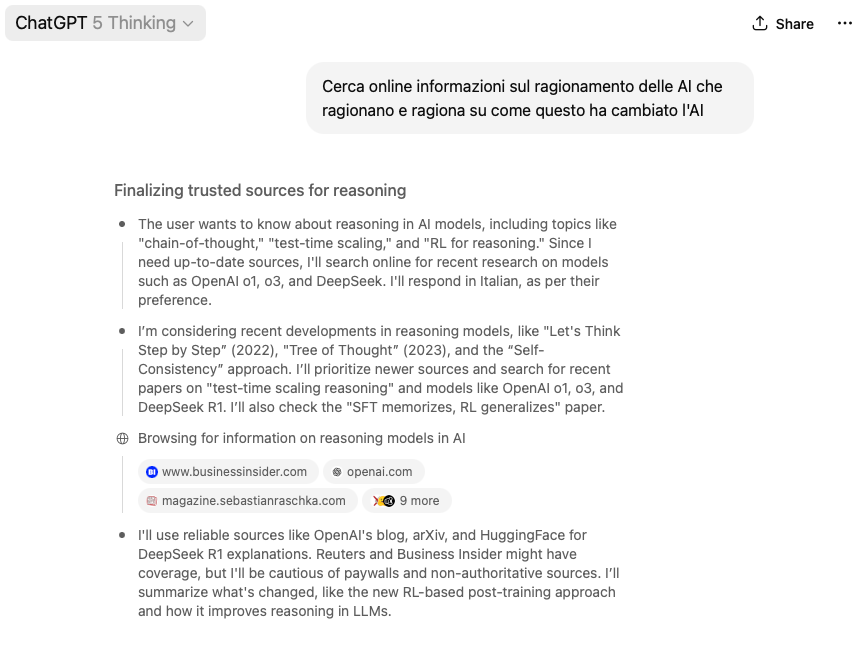

Oggi non solo è diventato normale, è la regola. Un’Assistente AI come ChatGPT è ormai considerato automaticamente “agentico” perché sa ragionare e interagire autonomamente con strumenti esterni anche mentre ragiona.

Ad esempio uno strumento è la web search. Che viene utilizzata per pensare su dati freschi.

Piattaforme agentiche come Manus.im ci hanno mostrato concretamente cosa vuol dire integrare ragionamento e tool esterni. Anche la Deep Research di Gemini, Claude e ChatGPT oggi è fatta così. Il modello non solo ragiona, ma nel farlo afferra un software esistente o qualunque altro tool digitale e lo usa per eseguire le nostre richieste, non solo per darci una risposta. È l’integrazione pratica di pensiero e azione.

3. I modelli potevano solo essere LARGE

Un anno fa non si parlava di modelli piccoli dedicati al ragionamento. Tutta l’attenzione era sui giganti: più grandi, più potenti, più abili, più impressionanti.

L’idea stessa che versioni compatte potessero ragionare era vista come una contraddizione in termini, non potevano esserci 'abilità emergenti' a dimensioni ridotte.

Oggi

Abbiamo versioni Small, Mini, Nano di ogni modello principale: modelli ‘distillati’ che ereditano molte capacità di ragionamento dei fratelli maggiori e li rendono accessibili, veloci, leggeri.

Small Reasoning Models anziché Large Language Models.

Sono diventati utilissimi nei flussi quotidiani perché permettono di distribuire il pensiero ovunque: dal server aziendale al telefono in tasca a costi decisamente più bassi e in tempi molto più brevi dei modelli più lunghi. Apple ci sta costruendo atttrno una strategia di lungo termine, qui trovate un modello che gira dentro ad un browser per riconoscere immagini.

È la democratizzazione del ragionamento, resa concreta, che potete trovare in ogni Assistente AI o su huggingface.co.

4. L’idea di oscurare i ragionamenti sembrava ridicola

Chi avrebbe mai pensato che il pensiero di un modello potesse diventare un vantaggio competitivo da proteggere? Un anno fa era impensabile: le catene di pensiero dei primi modelli come o1-Preview erano pubbliche, trasparenti, verbose. Ci si vantava del ragionamento dei propri modelli.

Oggi

Siamo entrati nell’era del ragionamento protetto. OpenAI ha chiuso le sue API a DeepSeek, Claude ha chiuso l’accesso alle API di OpenAI per presunte violazioni dei termini di licenza, OpenAI mostra solo i riassunti e tiene per sé i dettagli delle sue confabulazioni.

Motivo? Evitare che qualcuno faccia reverse engineering e scopra i segreti più profondi del modello.

È la prova che il modo in cui un’AI pensa, per la prima volta, è diventato un asset strategico.

Una prova ce l’avete nelle chiamate API nei cui risultati trovate contenuto criptato a cui non potete accedere (Ma che, ricordo, pagate).

Gli unici a mostrare tutto il ragionamento sono i sistemi open source. A volte anche troppo.

Provate questo prompt sui diversi modelli, che ragionano e non, di diversa dimensione e vedete cosa succede:

“Scrivi una bella composizione di [simpatico affetto tra vegetali] in terzine endecasillabe a rime baciate con struttura ABA BAB”Scoprirete presto che alcuni modelli hanno addirittura problemi di overthinking e voi non avete tempo e voglia di stare a vedere quello che dicono.

5. La geopolitica dell’AI era un tema per pochi eletti

Un anno fa, in pochi parlavano seriamente di geopolitica legata all’intelligenza artificiale. L’idea che i modelli di una nazione potessero essere più abili nel ragionare rispetto ad altri era chiara solo a pochi addetti ai lavori, sembrava roba da convegni accademici, lontana dalla vita reale.

Oggi

Con l’arrivo di modelli come Qwen e DeepSeek (cinesi), capaci di ragionare meglio in certi ambiti rispetto a o1 e GPT5, Claude, Grok, pur costando una frazione dei modelli americani, si è accesa una discussione su canali mainstream che ha di fatto portato qualunque persona interessata all’AI ad aver chiaro che quello geopolitico è un tema centrale.

Non è più solo tecnologia: è geopolitica. La qualità del ragionamento dei modelli è entrata nell’arena delle strategie internazionali. Ma io non ne parlerò 🙂.

6. Non si pensava alle nuove professioni agentiche

Parlare di mestieri legati alla gestione di agenti AI era visto come un esercizio di immaginazione. “Pastori di agenti”, “curatori di memorie”, “supervisori del ragionamento”: sembravano titoli da romanzo più che ruoli aziendali. Non c’era abbastanza sostanza perché qualcuno potesse prenderli sul serio.

Oggi

Il discorso è cambiato. La complessità degli agenti che ragionano, usano strumenti e memorie persistenti ha reso necessario creare nuove figure che sappiano comprendere come ragionano e come farli lavorare al meglio.

Capire come ragioni un agente, cosa dica a se stesso, cosa dica ai suoi colleghi agenti e cosa pensino a loro volta questi è un mestiere tutt’altro che semplice.

Quindi stiamo sentendo parlare sempre più di context engineer che costruiscono ambienti in cui gli agenti possono operare, di supervisori che verificano la qualità del ragionamento, di “accountability manager” che si prendono la responsabilità di decisioni ibride. Sono ruoli veri, che iniziano a comparire nei team come ho raccontato qualche settimana fa.

7. Il codice veniva generato solo se chiedevamo esplicitamente.

Un anno fa nessuno immaginava seriamente che un modello potesse non solo ragionare, ma anche generare ed eseguire direttamente il codice durante quel ragionamento. Sembrava un'idea assurda, troppo vicina alla fantascienza per essere presa sul serio. I modelli erano bravi a suggerire snippet di codice, certo, ma si fermavano lì e pochi osavano pensare oltre.

Oggi

Quella barriera è crollata.

I modelli SOTA (State Of The Art) non solo generano codice mentre ragionano, ma sono in grado di eseguirlo in tempo reale e usarne i risultati immediatamente per proseguire il pensiero. Non solo: lo fanno anche in modalità multimodale, gestendo insieme codice, testo, immagini e calcoli.

Si costruiscono gli strumenti che gli servono per produrre il risultato.

È come avere un assistente che, mentre spiega la sua idea, apre una console, scrive il codice, lo testa, corregge gli errori e poi ti mostra immediatamente il risultato. E questa, per chi sviluppa e per chi usa questi sistemi, non è più fantascienza—è la nuova normalità.

Nell’esempio sotto ho mostrato una foto ad o3 Chiedendo di identificare rischi e pericoli e come vedete ha messo in atto capacità multimodali e di generazione ed esecuzione di codice nello stesso ragionamento.

8. Il coding con l’AI era limitato e caotico

L’uso dei modelli per programmare era ancora artigianale: snippet di codice generati a colpi di prompt, spesso inutilizzabili senza una lunga revisione. Il sogno di un agente capace di sviluppare in autonomia applicazioni complete sembrava lontanissimo.

Oggi

Il ragionamento ha cambiato le regole anche qui. Sono esplose piattaforme come Lovable (la startup più veloce a crescere in Europa), Cursor o CODEX. Non parliamo più di un assistente che suggerisce righe di codice, ma di ambienti di sviluppo AI-native in cui l’agente ragiona, struttura, esegue test e mantiene il contesto.

È nato anche il Vibe Coding, un nuovo modo di costruire software anche da parte di chi non sa programmare, la programmazione che diventa conversazione.

Oggi è normale, almeno in certi ambienti, parlare di Agentic Engineering: quando un programmatore esperto incontra un agente che sa anche ragionare a lungo, anche per ore, su problemi complessi di sviluppo software.

9. Dare il controllo del browser ad un agente era per pochi.

Difficile anche solo immaginare un agente AI che aprisse un browser, navigasse tra link, modificasse file o gestisse applicazioni come una persona al computer. Fantascienza da convegno AI consumer.

Avevo fatto ricerche approfondite poco più di un anno fa e ancora si era nel mondo dell’RPA (Robotic Process Automation, tecnologia che va avanti da 20 anni)

Oggi

Operator, AgentGPT, Claude, Comet di Perplexity e mille altri per sviluppatori e piattaforme emergenti hanno reso normale che un agente governi un intero ambiente digitale solo con mouse e tastiera. Aprono, chiudono, installano, cancellano, configurano. Non chiedono più solo “cosa scrivere”, ma “cosa fare”. E lo fanno. Con tutte le implicazioni negative che vi vengono in mente. Un esempio su tutti è ChatGPT Agent.

10. La prompt injection era roba da nerd

Fino a poco tempo fa il problema della prompt injection era confinato a forum tecnici e a pochi addetti ai lavori. Sembrava un esercizio da laboratorio: chi mai avrebbe usato quelle tecniche nel mondo reale?

Oggi

Sapete tutti di cosa parlo vero? Ovvio 🙂

Ogni volta che facciamo una deep research o deleghiamo il nostro assistente AI a cercare sul web o tra documenti ‘non sicuri’ dobbiamo ricordarci che c’è il rischio di esporre contenuti sensibili della memoria dell’agente a potenziali attacchi.

Ovunque si possono trovare testi il cui obiettivo è manipolare il comportamento di questi ingenui ma potentissimi agenti, esfiltrando informazioni o eseguendo azioni non autorizzate nel vostro browser, pc o server.

Non pensarci equivale a essere irresponsabili. La cybersecurity e l’AI ormai sono intrecciate: non esiste più l’una senza l’altra.

È una minaccia concreta, e quando ne parlo nei workshop genero parecchie notti insonni.

11. Parlare di intelligenza ricorsiva era roba da nerd visionari.

È semplice, tranquilli.

Abbiamo capito che con un normale assistente AI funziona così:

Fai la domanda → ricevi risposta immediata.

Fine. Non c'è nessun’altra fase. Se fai altre domande, avrai altre risposte.

Oggi

Con l’intelligenza ricorsiva:

Fai una richiesta (Presenta il prodotto X al cliente Y)

L’assistente pensa e crea da solo un piano diviso in step (1. Analizzo il prodotto, 2. studio il cliente 3. adatto i contenuti)

Esegue ogni step autonomamente (O chiede conferma se gli è stato detto)

Verifica ogni volta che tutto vada bene, prima di consegnarti il risultato finale

Non è più una risposta secca, ma una sequenza intelligente di decisioni, verifiche e miglioramenti.

Un esempio grafico è qui:

Gli agenti ragionano su come ragionare. Pianificano a lungo termine, monitorano il proprio lavoro, riprendono i fili interrotti, imparano dai propri errori. Non sono più automi che eseguono: sono sistemi che riflettono e si correggono in corsa.

Di seguito un esempio di un compito che stavo dando ad un agente di coding. Vedete le fasi di pensiero (*Thinking) e il fatto che sta completando diverse fasi

✻ Thinking…

Perfect! Now I've completed the comprehensive documentation as requested. Let me mark Phase 3 as completed

and move on to Phase 4 - testing the complete flow.

Update Todos

⎿ ☒ Phase 1: Investigate current implementation

☒ Phase 1: Document Job() function and features

☒ Phase 1: Map current job storage (saveJob, updateJob)

☒ Phase 2: Modify api/index.ts to use JobManager

☒ Phase 2: Update job results endpoint to use JobManager

☒ Phase 2: Remove old processAsyncJob() function

☒ Phase 2: Remove old utility functions (saveJob, getJob, updateJob)

☒ Phase 2: Connect JobManager to AnalysisProcessor properly

☒ Phase 3: Create comprehensive documentation (.md files)

☐ Phase 4: Test complete flow and raw response storage

☐ Phase 5: Cleanup unused code and polish

✻ Thinking…

Perfect! Phase 3 is now complete with comprehensive documentation created:

1. ✅ I did this and that

Now I need to start Phase 4: [...]

⏺ 🎉 Phase 3 Complete! Created what you asked

Now starting Phase 4: Testing the complete flow. Let me run the verification script to ensure everything

works:

....

12. La parola Agente aveva un significato diverso

Un anno fa parlare di “agenti AI” faceva pensare a demo confuse e a esperimenti di laboratorio. O all’agente Smith di Matrix.

Gli LLM non ragionavano davvero, quindi l’idea che potessero diventare entità autonome, capaci di prendere decisioni o di gestire task complessi, sembrava fuori portata. Il massimo che si poteva ottenere era uno script che eseguiva passaggi rigidi e predeterminati. Nessuna agency, solo automazione fragile. E riservata a pochi addetti ai lavori.

Oggi

La parola agente ha ancora mille significati, in funzione di ciò che si vuole vendere.

Però gli agenti AI sono una realtà importante soprattutto perché i modelli hanno imparato a ragionare.

È il ragionamento che dà agli LLM la possibilità di pianificare, di scegliere percorsi alternativi, di usare strumenti mentre pensano.

Qualcuno parla di 'Sistemi Agentici' perchè mettono assieme ragionamento e strumenti software.

Nomi a parte non esisterebbero agenti così autonomi senza questa base cognitiva.

Hanno smesso di essere chatbot “con un compito minimo” e sono diventati colleghi digitali, con gradi diversi di autonomia, che richiedono supervisione ed agency. E come ho raccontato anche in questo articolo, queste capacità sono il tassello che ridefinirà il modo in cui lavoriamo.

13. Poco importava quanto a lungo ragionasse un’AI (in token e costi)

Un anno fa nessuno considerava seriamente il costo in token del ragionamento. Usavamo LLM per prompt rapidi, risposte immediate, e valutavamo i modelli solo sulla base della precisione o della coerenza. Il fatto che un ragionamento approfondito potesse costare decine o centinaia di volte più non era un problema concreto: tutto giocava in laboratorio, non in bilancio.

Oggi

È diventato vitale capire quanto a lungo un’AI può ragionare. Ragioniamo in termini di minuti, numero di token e costi reali. Tanto che si sta parlando addirittura di ‘nuova legge di Moore’

La performance, inoltre, non si misura più solo in durata, ma in token per risoluzione di un problema.

A parità di modello quanti token e quanto impiegano i modelli A, B, C per risolvere il problema X con la stessa percentuale di efficacia.

L’analisi iniziale, identica per tutti, ha richiesto costi molto diversi tra loro. Dovuti al mix tra costo/token e numero di token/task a parità di risultato.

E, per esperienza diretta, vi garantisco che è un tema importante!

Insomma, oggi valutiamo il costo dei modelli in base al tempo che impiegano, alla quantità di token e ovviamente al costo del singolo token.

Quindi…

In dodici mesi siamo passati da un'AI che sembrava un fenomeno da circo, una bolla sempre sul punto di esplodere, perchè incapace di un vero ragionamento, a modelli che oggi non solo ragionano, ma stanno cambiando concretamente il nostro modo di lavorare.

No, non sono ancora perfetti e il loro ragionamento a volte sembra un’arrampicata sugli specchi più che un percorso logico.

No, GPT-5 non ci ha portato l'AGI promessa da molti. Ma onestamente non importa, perché quello che abbiamo guadagnato è qualcosa di più pratico e vicino: modelli che hanno iniziato a simulare davvero il pensiero, che stanno imparando ad usare strumenti in modo sempre più efficace, che hanno trasformato il nostro rapporto con l’AI generativa.

Un anno fa i benchmark erano quasi saturi. Oggi stiamo vedendo progressioni esponenziali su nuovi test affrontabili solo da modelli in grado di pensare.

Un anno fa tutto questo sembrava molto difficile da realizzare, oggi è routine. E sembra siano passati 10 anni.

Non parliamo più di un semplice generatore di testo ma di una nuova entità a cui delegare parte del lavoro e con cui è possibile confrontarsi e ragionare (e sì, discutere) ogni giorno, in modo strutturato e complesso.

E allora, invece di continuare a lamentarci perché GPT-5 non è all’altezza delle aspettative che alcuni avevano, forse è il caso di goderci questo presente un po' assurdo ma straordinario: un'intelligenza artificiale che finalmente e davvero ragiona. Con tutte le implicazioni straordinarie che sta portando.

Ragioniamoci.

Massimiliano

Commenti